تلاش مایکروسافت برای ورود جدیتر به حوزه سختافزارهای اختصاصی هوش مصنوعی با چالشی جدی روبرو شده است. نسل جدید تراشه این شرکت با نام رمزی «براگا» (Braga)، که از سری Maia محسوب میشود، حداقل تا سال ۲۰۲۶ وارد مرحله تولید انبوه نخواهد شد؛ یعنی دستکم شش ماه دیرتر از برنامه اولیه.

تراشه اختصاصی هوش مصنوعی مایکروسافت

این تأخیر بار دیگر تردیدها را در مورد توانایی مایکروسافت برای رقابت با سلطه بلامنازع انویدیا در بازار تراشههای هوش مصنوعی افزایش داده و بر پیچیدگیهای فنی و سازمانی تولید تراشههای رقابتی تأکید دارد.

وابستگی سنگین به انویدیا و تلاش برای استقلال

مایکروسافت برنامه تولید تراشههای اختصاصی را با هدف کاهش وابستگی خود به پردازندههای گرافیکی (GPU) قدرتمند انویدیا آغاز کرد؛ پردازندههایی که ستون فقرات اکثر مراکز داده هوش مصنوعی در جهان را تشکیل میدهند. مشابه شرکتهای رقیب مانند آمازون و گوگل، مایکروسافت نیز سرمایهگذاری سنگینی برای توسعه سختافزارهای اختصاصی انجام داده است.

اما تأخیر جدید در عرضه تراشه براگا بدان معناست که این محصول، از نظر عملکرد، به احتمال زیاد از تراشههای جدید بلکول (Blackwell) انویدیا که در اواخر سال ۲۰۲۴ عرضه شدند، عقبتر خواهد بود. این موضوع شکاف تکنولوژیک بین مایکروسافت و انویدیا را عمیقتر میکند.

دشواریهای توسعه براگا

توسعه تراشه براگا با موانع متعددی همراه بوده است. منابع مطلع از این پروژه به The Information گفتهاند که تغییرات طراحی غیرمنتظره، کمبود نیروی انسانی و نرخ بالای ترک کارکنان از جمله عواملی بودهاند که به شکل مداوم برنامهریزی پروژه را به تعویق انداختهاند.

یکی از مهمترین موانع، درخواستی از سوی شرکت OpenAI – شریک کلیدی مایکروسافت – بوده است. این شرکت در مراحل پایانی توسعه، خواستار اضافه شدن ویژگیهای جدیدی شد که باعث بیثباتی عملکرد تراشه در شبیهسازیها گردید و در نهایت باعث تأخیر بیشتر شد. از سوی دیگر، فشار برای رعایت مهلتها منجر به افزایش فرسودگی شغلی در تیمهای توسعه شد و برخی تیمها تا ۲۰ درصد از اعضای خود را از دست دادند.

نگاهی به سری Maia و چشمانداز آن

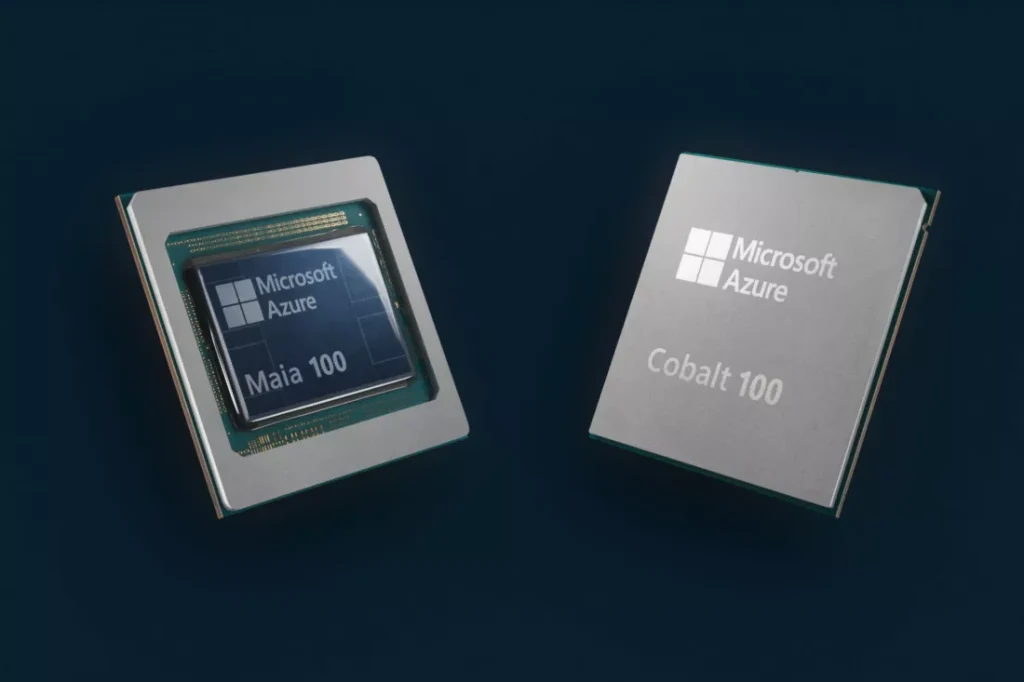

تراشههای سری Maia، از جمله مدل براگا، بخشی از استراتژی مایکروسافت برای یکپارچهسازی عمودی زیرساخت هوش مصنوعی خود محسوب میشوند. این تراشهها بهطور ویژه برای پردازشهای هوش مصنوعی در محیط ابری آژور طراحی شدهاند. نخستین مدل این سری، یعنی Maia 100، در اواخر سال ۲۰۲۳ معرفی شد و از فناوری پیشرفته ۵ نانومتری بهره میبرد. همچنین از سیستمهای مدیریت توان در سطح رک و خنکسازی مایع برای پاسخ به نیازهای حرارتی بالا استفاده میکند.

این تراشهها عمدتاً برای پردازش استنتاج (Inference) بهینهسازی شدهاند، نه برای آموزش مدلهای هوش مصنوعی، که بار پردازشی بسیار بالاتری دارد. این انتخاب طراحی با هدف پشتیبانی از سرویسهایی مانند Copilot و Azure OpenAI صورت گرفته است. با این حال، Maia 100 بیشتر در آزمایشهای داخلی استفاده شده و به دلیل طراحی قبل از موج اخیر مدلهای زبانی بزرگ و هوش مصنوعی مولد، هنوز کارایی گستردهای نیافته است.

انویدیا همچنان پیشتاز بیرقیب

در سوی دیگر، تراشههای Blackwell از انویدیا که از اواخر ۲۰۲۴ عرضه شدند، برای هر دو مرحله آموزش و استنتاج در مقیاس وسیع طراحی شدهاند. این تراشهها با بیش از ۲۰۰ میلیارد ترانزیستور و بهرهمندی از فرآیند اختصاصی شرکت TSMC، عملکردی فوقالعاده و بهرهوری انرژی بالایی دارند. همین مزایا، جایگاه انویدیا را به عنوان تأمینکننده اصلی زیرساختهای هوش مصنوعی در جهان مستحکمتر کرده است.

رقابت سنگین با رقبای دیگر

اهمیت رقابت در بازار تراشههای هوش مصنوعی بسیار بالاست. تأخیر مایکروسافت به معنای تداوم وابستگی بیشتر مشتریان Azure به سختافزارهای انویدیا است؛ موضوعی که میتواند هم هزینهها را افزایش دهد و هم توان مایکروسافت در ایجاد تمایز بین خدمات ابری خود و رقبا را کاهش دهد.

در همین حال، آمازون و گوگل نیز با قدرت به توسعه تراشههای اختصاصی خود ادامه میدهند؛ بهویژه تراشه Trainium 3 از آمازون و نسل هفتم واحدهای پردازش تنسور (TPU) گوگل که روز به روز حضور پررنگتری در مراکز داده پیدا میکنند.

نظرات کاربران