NVIDIA طیف وسیعی از واحدهای پردازش گرافیکی (GPUs) را ارائه میدهد که به طور ویژه برای تسریع بار کاری هوش مصنوعی (AI)، مانند A100 و H200، طراحی شدهاند. بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 مجهز به ویژگیها و معماریهایی برای مدیریت نیازهای محاسباتی هوش مصنوعی، مانند یادگیری ماشین (Machine Learning)، یادگیری عمیق (Deep Learning) و پردازش دادههای بزرگ (Big Data) هستند. این کارتهای گرافیک در صنایع مختلف برای ارائه آموزش و استنتاج کارآمد مدلهای هوش مصنوعی استفاده میشوند.

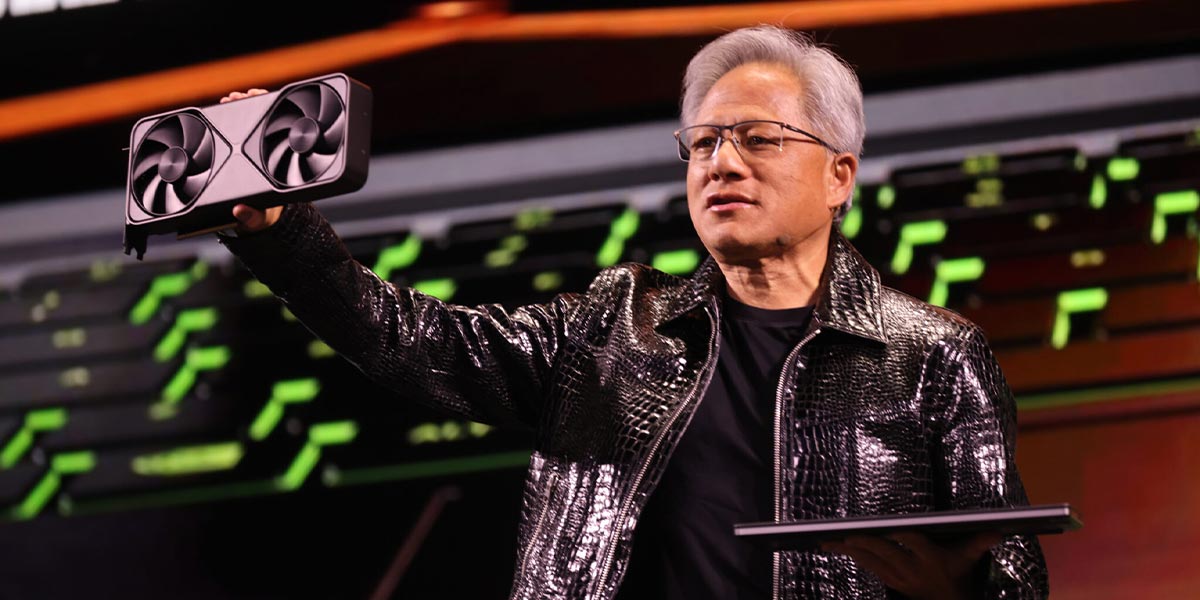

NVIDIA همچنین GPUهای رده مصرفکننده، مانند RTX 6000 را ارائه میدهد که به طور خاص برای بار کاری هوش مصنوعی طراحی نشدهاند، اما همچنان میتوانند به طور موثر آن را تسریع کنند و هزینه بسیار کمتری دارند. سازمانها و توسعهدهندگان فردی با استفاده از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 تخصصی یا GPUهای رده بالای مصرفکننده میتوانند قدرت محاسباتی مورد نیاز برای انجام پروژههای جاهطلبانه هوش مصنوعی را به دست آورند.

مروری بر خط تولید بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025

در ادامه معرفی بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، قصد داریم مروری بر خط تولید این برند داشته باشیم. در نتیجه با ما همراه باشید تا اطلاعات جامعتری را در اختیار شما قرار دهیم.

کارتهای گرافیک دیتا سنتر NVIDIA

GPUهای دیتا سنتر NVIDIA، مانند کارت گرافیک هسته تنسور A100، برای محیطهای محاسباتی با کارایی بالا طراحی شدهاند. این کارتهای گرافیک قدرت پردازشی را برای بار کاری هوش مصنوعی فراهم میکنند و به دیتا سنترها اجازه میدهند تا مقادیر وسیعی از دادهها را به راحتی مدیریت کنند. بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 آموزش مدل در مقیاس بزرگ را فعال کرده و برنامههای هوش مصنوعی و HPC را تسریع میکنند.

کارتهای گرافیک دیتا سنتر NVIDIA با ظرفیت حافظه عظیم و قابلیتهای GPU چند نمونهای، کارایی و عملکرد مقیاسپذیر را ارائه میدهند. آنها در زیرساختهای دیتا سنتر ادغام میشوند و استفاده از منابع و بهرهوری انرژی را بهینه میکنند. کارتهای گرافیک دیتا سنتر NVIDIA قابلیتهای زیر را ارائه میدهند:

- هستههای تنسور و تسریع هوش مصنوعی: هستههای تنسور محاسبات را برای وظایف هوش مصنوعی بهبود میبخشند. این هستهها ضرب ماتریسها را که در آموزش مدلهای یادگیری عمیق بسیار مهم هستند؛ بهینه میکنند و امکان پردازش سریعتر با مصرف انرژی کمتر را فراهم میکنند. این هستهها مدیریت کارآمد عملیات هوش مصنوعی را ارائه میدهند و در نتیجه زمان آموزش مدلها کاهش مییابد. هستههای تنسور همچنین از آموزش با دقت مختلط پشتیبانی میکنند و عملکرد را بدون کاهش دقت بهبود میبخشند.

- پهنای باند و ظرفیت حافظه بالا: بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 میتوانند مجموعه دادههای بزرگ را مدیریت کرده و مدلهای پیچیده هوش مصنوعی را اجرا کنند. پهنای باند بالای آنها اطمینان میدهد که دادهها به سرعت بین پردازنده و حافظه منتقل میشوند، که برای عملکرد در وظایف سنگین محاسباتی مانند یادگیری عمیق بسیار مهم است. ظرفیت حافظه بالا از ذخیرهسازی و دستکاری مدلها و مجموعه دادههای بزرگ پشتیبانی میکند.

- معماری CUDA و مدل برنامهنویسی: بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، یک پلتفرم برای محاسبات موازی فراهم میکنند. CUDA توسعهدهندگان را قادر میسازد تا از قدرت GPU برای برنامههای متنوع استفاده کنند و عملکرد را در سراسر وظایف محاسباتی مختلف با موازیسازی فرآیندها بهبود بخشند. مدل برنامهنویسی امکان ادغام و بهینهسازی آسان بار کاری هوش مصنوعی در اکوسیستم NVIDIA را فراهم میکند. CUDA پشتیبانی گسترده کتابخانهای و منابع جامعه را ارائه میدهد.

کارتهای گرافیک رده مصرفکننده NVIDIA

انویدیا همچنین GPUهای رده مصرفکننده را ارائه میدهد که برای متخصصان خلاق و مهندسان در نظر گرفته شدهاند و عملکرد و قابلیت اطمینان را برای برنامههای کاربردی سنگین ارائه میدهند. بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، به ویژه سری RTX، به طور ویژه برای وظایفی مانند رندرینگ سه بعدی و شبیهسازیها بهینه شدهاند، اما برای بار کاری هوش مصنوعی نیز موثر هستند.

GPUهای رده مصرفکننده NVIDIA از گردش کار در صنایعی مانند رسانه، سرگرمی و معماری پشتیبانی میکنند و همچنین به طور گسترده توسط توسعهدهندگان و مهندسان هوش مصنوعی مورد استفاده قرار میگیرند.

موارد استفاده رایج هوش مصنوعی برای GPUهای انویدیا

بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، در چندین حوزه مفید هستند، راهحلهای هوش مصنوعی را تسریع کرده و قابلیتهای محاسباتی را بهبود میبخشند.

آموزش و استنتاج هوش مصنوعی در دیتا سنترها

در دیتاسنترها بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، بار کاری آموزش و استنتاج هوش مصنوعی را با کارایی بیشتری هدایت میکنند. آنها امکان پردازش سریع مجموعه دادههای بزرگ را فراهم میکنند و توسعه و استقرار سریعتر مدلهای هوش مصنوعی را ممکن میسازند. این GPUها وظایف هوش مصنوعی را به طور قابل اعتماد انجام میدهند و آنها را برای مراکز دادهای که قصد دارند خدمات هوش مصنوعی را پیادهسازی یا مقیاسبندی کنند؛ مناسب مینماید.

محاسبات لبهای (Edge Computing) و دستگاههای هوشمند

بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 از برنامههای کاربردی محاسبات لبهای پشتیبانی میکنند و دستگاههای هوشمند را برای پردازش دادهها به صورت محلی بهینه میکنند. این امر تأخیر را به حداقل میرساند و عملکرد برنامههای کاربردی بلادرنگ در وسایل نقلیه خودران، تشخیص پزشکی و اینترنت اشیا را افزایش میدهد. NVIDIA با ارائه قابلیتهای هوش مصنوعی روی دستگاه، محاسبات کارآمد منابع را در نزدیکی محل تولید دادهها تضمین میکند.

توسعه برنامههای هوش مصنوعی

بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، توسعهدهندگان را قادر میسازند تا طیف گستردهای از برنامههای هوش مصنوعی را بسازند و بهینه کنند. این GPUها آموزش و استقرار کارآمد مدلهای یادگیری ماشین را برای وظایفی مانند بینایی کامپیوتر، پردازش زبان طبیعی و رباتیک امکانپذیر میسازند.

توسعهدهندگان میتوانند از پشته نرمافزاری NVIDIA، از جمله CUDA، TensorRT و TAO Toolkit، برای سادهسازی گردش کار و بهبود عملکرد استفاده کنند. این ابزارها بهینهسازی مدل، تنظیم دقیق و ادغام در محیطهای تولید را تسهیل میکنند.

بهترین کارتهای گرافیک دیتا سنتر انویدیا

کارت گرافیک A100 Tensor Core

ویژگیهای کلیدی:

- هستههای Tensor نسل سوم: تا 312TFLOPS عملکرد یادگیری عمیق ارائه میدهند، از دقت ترکیبی پشتیبانی میکنند و امکان پیشرفت در آموزش و استنتاج هوش مصنوعی را فراهم میآورند.

- حافظه با پهنای باند بالا (HBM2e): تا 80 گیگابایت حافظه با پهنای باند 2 ترابایت بر ثانیه دسترسی سریع به دادهها و پردازش کارآمد مدل را تضمین میکند.

- GPU چند نمونهای (MIG): امکان تقسیم واحد کارت گرافیک A100 به هفت نمونه ایزوله را فراهم میکند که هر کدام دارای منابع اختصاصی هستند و استفاده از GPU را برای بارهای کاری ترکیبی بهینه میسازند.

- NVLink نسل بعدی: پهنای باند اتصال متقابل تا 600 گیگابایت در ثانیه را با 2 برابر توان عملیاتی نسل قبلی ارائه میدهد و مقیاسبندی چند GPU یکپارچه را ممکن میسازد.

- تراکم ساختاری: با بهینهسازی مدلهای پراکنده، عملکرد هوش مصنوعی را بهبود میبخشد و توان عملیاتی را برای برخی وظایف استنتاج دو برابر میکند.

مشخصات:

- هسته تنسور FP64: برابر با 19.5TFLOPS

- Tensor Float 32 (TF32): برابر با 156TFLOPS (با تراکم 312TFLOPS)

- هسته تنسور FP16: برابر با 312TFLOPS (با تراکم 624TFLOPS)

- هسته تنسور INT8: برابر با 624 TOPS (با تراکم 1,248TOPS)

- حافظه: 40GB HBM2 یا 80GB HBM2e

- پهنای باند: تا 2,039 گیگابایت در ثانیه

- توان حرارتی طراحی: 250 وات (PCIe) تا 400 وات (SXM)

- فرمتها: PCIe و SXM4

- NVLink: پهنای باند اتصال متقابل تا 600 گیگابایت در ثانیه

- سرعت PCIe Gen4: برابر با 64 گیگابایت در ثانیه

- از سیستمهای NVIDIA HGX A100 با حداکثر 16 کارت گرافیک پشتیبانی میکند.

کارت گرافیک انویدیا A100 Tensor Core، یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 و راهحلی برای تسریع بارهای کاری متنوع در زمینه هوش مصنوعی، HPC و تجزیه و تحلیل داده است. این محصول با ارائه عملکردی تا 20 برابر بهتر از نسل قبلی خود، Volta، میتواند به صورت پویا مقیاسبندی شود و تا هفت نمونه GPU تقسیم شود تا استفاده از منابع بهینه گردد.

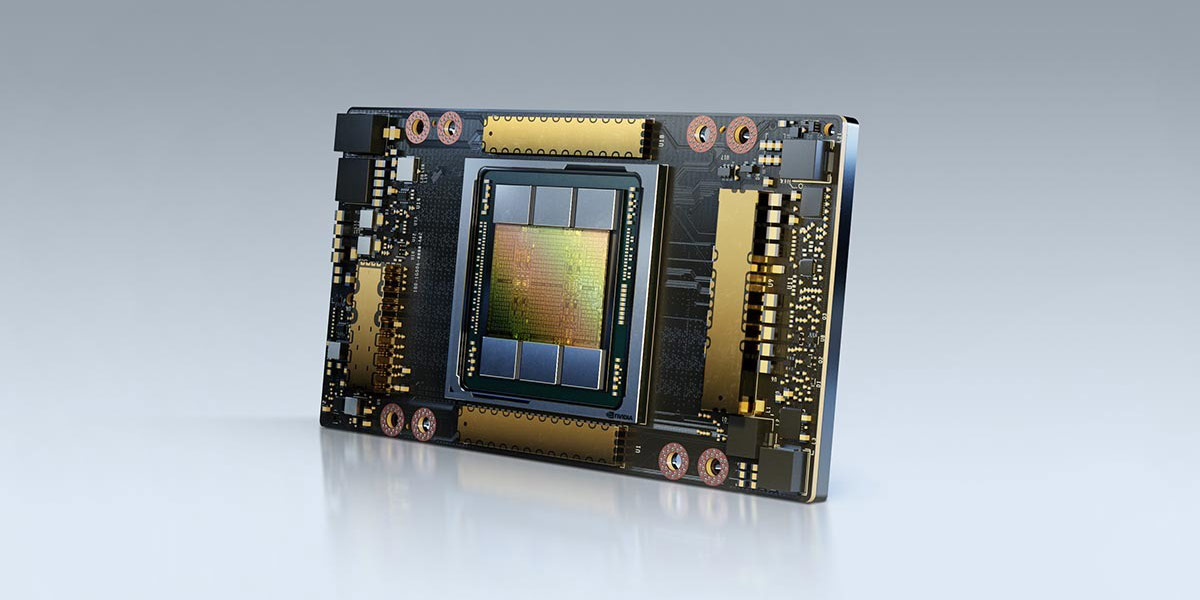

کارت گرافیک H100 Tensor Core

ویژگیهای کلیدی:

- هستههای Tensor نسل چهارم: عملکرد را در طیف وسیعی از دقتها (FP64، FP32، FP16، FP8 و INT8) ارائه میدهد و از پشتیبانی متنوع برای LLMها و برنامههای HPC اطمینان حاصل میکند.

- موتور Transformer: به طور خاص برای LLMهای تریلیون پارامتری طراحی شده است و عملکرد استنتاجی تا 30 برابر سریعتر و آموزش مدلهای GPT-3 را تا 4 برابر سریعتر ارائه میدهد.

- حافظه با پهنای باند بالا (HBM3): تا 94 گیگابایت حافظه با پهنای باند 3.9 ترابایت در ثانیه برای دسترسی سریعتر به دادهها و مدیریت مدلهای در مقیاس بزرگ فراهم میکند.

- محاسبات محرمانه NVIDIA: یک محیط اجرای مورد اعتماد (TEE) مبتنی بر سختافزار امن را برای محافظت از دادهها و بارهای کاری معرفی میکند.

- GPU چند نمونهای (MIG): امکان تقسیم به حداکثر هفت نمونه GPU را فراهم میکند و استفاده از منابع را برای بارهای کاری متنوع با دانهبندی بهبودیافته بهینه میسازد.

- NVLink نسل بعدی: دارای پهنای باند اتصال متقابل تا 900 گیگابایت در ثانیه است که ارتباط چند GPU را برای سیستمهای در مقیاس بزرگ امکانپذیر میسازد.

مشخصات:

- هسته تنسور FP64: برابر با 67 ترافلاپس

- هسته تنسور TF32: برابر با 989 ترافلاپس

- هسته تنسور FP16: برابر با 1,979 ترافلاپس

- هسته تنسور FP8: برابر با 3,958 ترافلاپس

- ظرفیت: 80 گیگابایت (SXM) یا 94 گیگابایت (NVL)

- پهنای باند: تا 3.9 ترابایت در ثانیه

- توان حرارتی طراحی: تا 700 وات (SXM) یا 400 وات (PCIe)

- فرمتها: SXM و PCIe دو اسلاته

- NVLink: پهنای باند 900 گیگابایت در ثانیه (SXM) یا 600 گیگابایت در ثانیه (PCIe)

- سرعت PCIe Gen5: برابر با 128 گیگابایت در ثانیه

- سازگار با سیستمهای NVIDIA HGX H100 (با 4–8 کارت گرافیک) و سیستمهای NVIDIA DGX H100 (با 8 کارت گرافیک).

کارت گرافیک NVIDIA H100 Tensor Core بر اساس معماری NVIDIA Hopper ساخته شده است و عملکرد، مقیاسپذیری و امنیت را برای بارهای کاری ارائه میدهد. H100 که یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 است؛ با استنتاج و آموزش سریعتر برای مدلهای زبانی بزرگ (LLM) نسبت به نسل قبلی خود، شامل هستههای Tensor نسل چهارم، موتور Transformer و ویژگیهای خاص Hopper مانند محاسبات محرمانه است که محاسبات سازمانی و کلان مقیاس را دوباره تعریف میکند.

کارت گرافیک H200 Tensor Core

ویژگیهای کلیدی:

- حافظه HBM3e: مجهز به 141 گیگابایت حافظه HBM3e است که پهنای باند 4.8 ترابایت در ثانیه را ارائه میدهد. این بهبود تقریباً ظرفیت و پهنای باند حافظه نسل قبلی خود، H100، را دو برابر میکند و پردازش سریعتر دادهها را برای LLMها و برنامههای HPC امکانپذیر میسازد.

- عملکرد بهبود یافته هوش مصنوعی و HPC: در مقایسه با H100، استنتاج Llama2 70B را تا 1.9 برابر سریعتر و استنتاج GPT-3 175B را تا 1.6 برابر سریعتر ارائه میدهد و اجرای سریعتر وظایف هوش مصنوعی مولد را تضمین میکند. برای بارهای کاری HPC، زمان رسیدن به نتایج را تا 110 برابر سریعتر از سیستمهای مبتنی بر CPU ارائه میدهد.

- بهرهوری انرژی: همان مشخصات توان H100 را حفظ میکند و بهرهوری انرژی بهتر و کاهش هزینههای عملیاتی را تضمین میکند.

- GPU چند نمونهای (MIG): از حداکثر هفت نمونه در هر GPU پشتیبانی میکند و امکان تقسیم کارآمد برای بارهای کاری متنوع و استفاده بهینه از منابع را فراهم میآورد.

- محاسبات محرمانه: محیطهای اجرای مورد اعتماد (TEE) مبتنی بر سختافزار، مدیریت امن بارهای کاری حساس را فراهم میکنند.

مشخصات:

- هسته تنسور FP64: برابر با 67 ترافلاپس

- هسته تنسور FP32: برابر با 989 ترافلاپس

- هسته تنسور FP16/FP8: برابر با 1,979 ترافلاپس / 3,958 ترافلاپس

- حافظه: 141GB HBM3e

- پهنای باند حافظه: 4.8 ترابایت در ثانیه

- نمونههای MIG: تا 7 (18GB در هر نمونه MIG در SXM، 16.5GB در NVL)

- توان حرارتی طراحی: قابل تنظیم تا 700 وات (SXM) یا 600 وات (NVL)

- فرمت: گزینههای SXM یا PCIe دو اسلاته با خنککننده هوا

- اتصال متقابل: NVIDIA NVLink: برابر با 900 گیگابایت در ثانیه و PCIe Gen5: 128 گیگابایت در ثانیه

کارت گرافیک NVIDIA H200 Tensor Core بر اساس معماری Hopper ساخته شده است. این GPU که یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 است؛ ویژگیهای عملکردی جدیدی مانند حافظه HBM3e، بهبود بهرهوری انرژی و توان عملیاتی بالاتر را برای مدلهای زبانی بزرگ و بارهای کاری علمی معرفی میکند.

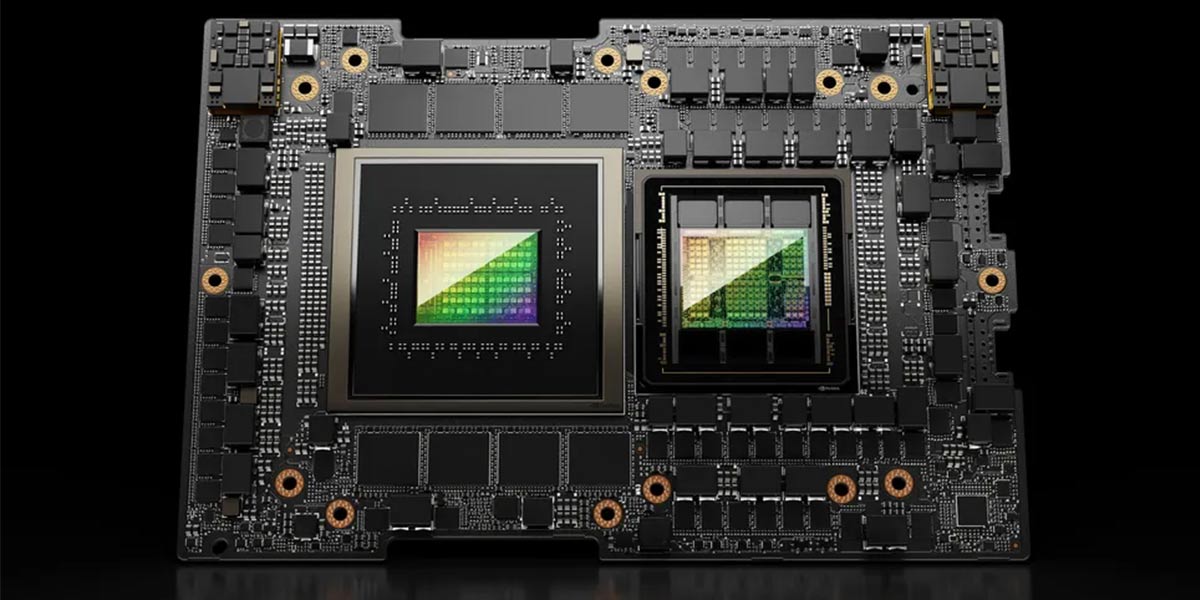

کارت گرافیک GB200 NVL72

ویژگیهای کلیدی:

- معماری Blackwell: محاسبات در کلان مقیاس را با عملکرد و کارایی بینظیر امکانپذیر میسازد.

- موتور Transformer نسل دوم: از دقت FP4 و FP8 پشتیبانی میکند و آموزش و استنتاج هوش مصنوعی را تسریع میبخشد.

- NVLink نسل پنجم: ارتباط GPU با سرعت بالا را با پهنای باند 130 ترابایت در ثانیه برای عملیات چند GPU کارآمد تضمین میکند.

- خنککننده مایع: مصرف انرژی و ردپای کربن در دیتا سنتر را کاهش میدهد و در عین حال تراکم محاسباتی بالا را حفظ میکند.

- CPU Grace: عملکرد فوقالعادهای را با حداکثر 17 ترابایت حافظه و پهنای باند 18.4 ترابایت در ثانیه ارائه میدهد.

مشخصات:

- هسته تنسور FP4: برابر با 1,440 پتافلاپس

- هسته تنسور FP16/BF16: برابر با 360 پتافلاپس

- FP64: برابر با 3,240 ترافلاپس

- پهنای باند حافظه: تا 13.5 ترابایت HBM3e و 576 ترابایت در ثانیه

- تعداد هسته پردازنده: 2,592 هسته Arm Neoverse V2

- حافظه: تا 17 ترابایت LPDDR5X و 18.4 ترابایت در ثانیه پهنای باند

- پهنای باند NVLink: برابر با 130 ترابایت در ثانیه

انویدیا GB200 NVL72 یک راهحل دیتا سنتر برای محاسبات با کارایی بالا (HPC) و بارهای کاری هوش مصنوعی است. این سیستم با معماری در مقیاس رک با 36 پردازنده Grace و 72 کارت گرافیک Blackwell، عملکردی بینظیر برای مدلهای هوش مصنوعی تریلیون پارامتری ارائه میدهد. همچنین شامل اجزایی مانند موتور Transformer نسل دوم، اتصال متقابل NVLink-C2C و خنک کننده مایع است. همین امر آن را تبدیل به یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 میکند.

کارتهای گرافیکی مصرفکننده NVIDIA برای هوش مصنوعی

خط تولید کارتهای گرافیک مصرفکننده NVIDIA شامل چندین مدل است که میتوانند برای موارد هوش مصنوعی به کار روند. در ادامه به بررسی بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 میپردازیم.

کارت گرافیک RTX 6000 Ada Generation

ویژگیهای کلیدی:

- معماری Ada Lovelace: عملکردی تا 2 برابر بیشتر از نسل قبلی خود را برای شبیهسازیها، هوش مصنوعی و بارهای کاری گرافیکی ارائه میدهد.

- هستههای RT نسل سوم: ردیابی پرتو تا 2 برابر سریعتر را برای رندرینگ فوتورئالیستی، نمونهسازی مجازی و دقت تاری حرکت ارائه میدهد.

- هستههای Tensor نسل چهارم: وظایف هوش مصنوعی را با دقت FP8 تسریع میکند و عملکرد بالاتری را برای آموزش و استنتاج مدل ارائه میدهد.

- 48 گیگابایت حافظه GDDR6: از مجموعههای دادههای عظیم و بارهای کاری پیشرفته از جمله علم داده، رندرینگ و شبیهسازیهای هوش مصنوعی پشتیبانی میکند.

- رمزگذارهای AV1: کارایی 40 درصد بیشتری نسبت به H.264 ارائه میدهد و کیفیت پخش ویدیو را بهبود میبخشد و استفاده از پهنای باند را کاهش میدهد.

- آماده برای مجازیسازی: از نرمافزار NVIDIA RTX Virtual Workstation (یا vWS) پشتیبانی میکند و امکان اشتراکگذاری منابع برای بارهای کاری از راه دور با کارایی بالا را فراهم میکند.

مشخصات:

- تک دقت: 91.1 ترافلاپس

- عملکرد هسته RT: برابر با 210.6 ترافلاپس

- عملکرد هوش مصنوعی هسته Tensor: برابر با 1,457 TOPS (نظری FP8 با تراکم)

- دارای 48 گیگابایت GDDR6 با ECC

- پهنای باند: سرعت بالا برای برنامههای کاربردی سنگین

- حداکثر مصرف برق: 300 وات

- ابعاد: 11.176 سانتیمتر (ارتفاع) و 26.67 سانتیمتر (طول) دو اسلاته، خنککننده فعال

- خروجیهای نمایشگر: چهار DisplayPort 1.4

- گذرگاه گرافیکی: PCIe Gen 4 x16

- پروفایلهای vGPU پشتیبانی شده: NVIDIA RTX vWS، NVIDIA vPC/vApps

کارت گرافیک NVIDIA RTX 6000 Ada Generation برای بارهای کاری حرفهای از جمله رندرینگ، هوش مصنوعی، شبیهسازی و تولید محتوا طراحی شده است. این کارت گرافیک که بر اساس معماری NVIDIA Ada Lovelace ساخته شده تبدیل به یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 شده است و هستههای CUDA نسل بعدی، هستههای RT نسل سوم و هستههای Tensor نسل چهارم را برای ارائه عملکردی تا 10 برابر بیشتر از نسل قبلی ترکیب میکند.

کارت گرافیک NVIDIA RTX A6000

ویژگیهای کلیدی:

- هستههای CUDA با معماری Ampere: عملیات FP32 با سرعت دو برابر، عملکرد را برای کارهای گرافیکی و شبیهسازی مانند CAD و CAE بهبود میبخشد.

- هستههای RT نسل دوم: 2 برابر توان عملیاتی نسل قبلی را برای ردیابی پرتو، سایهزنی و حذف نویز ارائه میدهند و نتایج سریعتر و دقیقتری را به دست میدهند.

- هستههای Tensor نسل سوم: آموزش مدلهای هوش مصنوعی را با حداکثر 5 برابر توان عملیاتی نسل قبلی تسریع میکنند و از پراکندگی ساختاری برای افزایش کارایی استنتاج پشتیبانی میکنند.

- 48 گیگابایت حافظه GDDR6: با NVLink تا 96 گیگابایت قابل ارتقا است و ظرفیت لازم برای مجموعههای داده بزرگ و گردشهای کاری با عملکرد بالا را فراهم میکند.

- NVLink نسل سوم: پهنای باند GPU به GPU تا 112 گیگابایت در ثانیه را امکانپذیر میسازد و از مقیاسپذیری حافظه و عملکرد برای پیکربندیهای چند کارت گرافیک پشتیبانی میکند.

- آماده برای مجازیسازی: امکان ایجاد چندین نمونه ایستگاه کاری مجازی با عملکرد بالا را با پشتیبانی از NVIDIA RTX Virtual Workstation و سایر راهکارهای vGPU فراهم میکند.

- بهرهوری انرژی: طراحی دو اسلات، تا دو برابر بهرهوری انرژی بیشتری نسبت به پردازندههای گرافیکی Turing نسل قبلی ارائه میدهد.

مشخصات:

- هستههای CUDA: معماری با عملکرد بالا برای حجمهای کاری سنگین

- توان عملیاتی هسته RT: دو برابر نسل قبلی

- توان عملیاتی آموزش هسته Tensor: پنج برابر نسل قبلی

- 48 گیگابایت GDDR6 با ECC (قابل ارتقاء تا 96 گیگابایت با NVLink)

- حداکثر مصرف برق: 300 وات

- ابعاد: 11.176 سانتیمتر (ارتفاع) و 26.67 سانتیمتر (طول)، دو اسلات، خنککننده فعال

- خروجیهای نمایشگر: چهار DisplayPort 1.4a

- PCIe Gen 4 x16: سرعت انتقال داده پیشرفته

- پشتیبانی از: NVIDIA vPC/vApps، RTX Virtual Workstation و Virtual Compute Server

NVIDIA RTX A6000 یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، محاسبات پیشرفته، رندرینگ و حجمهای کاری هوش مصنوعی است. این کارت که با معماری NVIDIA Ampere قدرت گرفته است، هستههای RT نسل دوم، هستههای Tensor نسل سوم و 48 گیگابایت حافظه GDDR6 فوقسریع را ترکیب میکند تا عملکرد بالایی را برای متخصصان ارائه دهد.

کارت گرافیک NVIDIA RTX A5000

ویژگیهای کلیدی:

- هستههای CUDA با معماری Ampere: تا 2.5 برابر عملکرد FP32 نسل قبلی را ارائه میدهد و بارهای کاری گرافیکی و شبیهسازی را بهینه میکند.

- هستههای RT نسل دوم: عملکرد ردیابی پرتو تا 2 برابر سریعتر و تاری حرکت شتابیافته سختافزاری را برای رندرینگ دقیق و با سرعت بالا فراهم میکند.

- هستههای Tensor نسل سوم: آموزش مدلهای هوش مصنوعی را با پراکندگی ساختاری تا 10 برابر سریعتر امکانپذیر میسازد و وظایف تقویتشده با هوش مصنوعی مانند حذف نویز و DLSS را تسریع میکند.

- 24 گیگابایت حافظه GDDR6: مجهز به ECC برای تصحیح خطا، که قابلیت اطمینان را برای حجمهای کاری سنگین حافظه مانند تولید مجازی و شبیهسازیهای مهندسی تضمین میکند.

- NVLink نسل سوم: تنظیمات چندگانه GPU را با پهنای باند اتصال داخلی تا 112 گیگابایت در ثانیه و حافظه ترکیبی 48 گیگابایت برای مدیریت مجموعههای داده و مدلهای بزرگتر امکانپذیر میسازد.

- آماده برای مجازیسازی: از نرمافزار NVIDIA RTX Virtual Workstation (یا vWS) برای تبدیل ایستگاههای کاری به نمونههای مجازی با عملکرد بالا برای بارهای کاری از راه دور پشتیبانی میکند.

- بهرهوری انرژی: طراحی دو اسلات با بهرهوری انرژی تا 2.5 برابر بهتر از نسل قبلی را ارائه میدهد و با طیف گستردهای از ایستگاههای کاری حرفهای سازگار است.

- PCI Express Gen 4: سرعت انتقال داده از حافظه CPU را بهبود میبخشد و عملکرد را در وظایف سنگین داده افزایش میدهد.

مشخصات:

- هستههای CUDA: معماری با عملکرد بالا برای گردشهای کاری پیشرفته

- عملکرد هسته RT: دو برابر نسل قبلی

- عملکرد آموزش هسته Tensor: تا 10 برابر نسل قبلی

- 24 گیگابایت GDDR6 با ECC (قابل ارتقا تا 48 گیگابایت با NVLink)

- حداکثر مصرف برق: 230 وات

- ابعاد: 11.176 سانتیمتر (ارتفاع) و 26.67 سانتیمتر (طول)، دو اسلات، خنککننده فعال

- خروجیهای نمایشگر: چهار DisplayPort 1.4

- PCIe Gen 4 x16: انتقال داده سریعتر برای برنامههای کاربردی سنگین

- پشتیبانی از: NVIDIA vPC، vApps، RTX vWS و Virtual Compute Server

کارت گرافیک NVIDIA RTX A5000 عملکرد، کارایی و قابلیت اطمینان را برای پاسخگویی به نیازهای گردشهای کاری پیچیده حرفهای ترکیب میکند. این کارت که با معماری NVIDIA Ampere قدرت گرفته یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 و دارای 24 گیگابایت حافظه GDDR6، هستههای RT نسل دوم و هستههای Tensor نسل سوم برای تسریع وظایف هوش مصنوعی، رندرینگ و شبیهسازی است.

کارت گرافیک GeForce RTX 4090

ویژگیهای کلیدی:

- معماری Ada Lovelace: تا دو برابر عملکرد و بهرهوری انرژی بیشتری را ارائه میدهد و برنامههای کاربردی پیشرفته بازی و خلاقانه را به پیش میبرد.

- هستههای RT نسل سوم: ردیابی پرتو سریعتری را ارائه میدهد و نورپردازی، سایهها و بازتابهای فوقالعاده واقعی را امکانپذیر میسازد.

- هستههای Tensor نسل چهارم: عملکرد هوش مصنوعی را تا 4 برابر قدرت رندرینگ brute-force بهبود میبخشد و از DLSS 3 برای گیمپلی فوقالعاده روان پشتیبانی میکند.

- 24 گیگابایت حافظه GDDR6X: عملکرد یکپارچه را برای وظایف بازی و خلاقانه در مقیاس بزرگ، از جمله رندرینگ سهبعدی و مدلسازی هوش مصنوعی، تضمین میکند.

- NVIDIA DLSS 3: فناوری ارتقاء مقیاس مبتنی بر هوش مصنوعی که نرخ فریم را افزایش میدهد و تصاویر واضح را بدون افت کیفیت تصویر ارائه میدهد.

- NVIDIA Reflex: تأخیر سیستم را برای برتری رقابتی در بازیهای سریع کاهش میدهد.

- NVIDIA Studio: بارهای کاری خلاقانه را با ابزارهای بهینهشده برای سازندگان، از جمله RTX Video Super Resolution و NVIDIA Broadcast، تسریع میکند.

- درایورهای Game Ready و Studio: پایداری و عملکرد بهینه را برای برنامههای کاربردی بازی و تولید محتوا فراهم میکنند.

مشخصات:

- تعداد هستهها: 16,384 هسته CUDA

- سرعت کلاک پایه/بوست: 2,235–2,520 مگاهرتز

- هستههای Ray Tracing: برابر با 128

- هستههای تنسور: 512

- عملکرد نظری: 82.6 ترافلاپس (FP32)

- ظرفیت: 24 گیگابایت GDDR6X

- پهنای گذرگاه حافظه: 384 بیت

- پهنای باند: 1,008 گیگابایت بر ثانیه

- مصرف برق: 450 وات

- تعداد ترانزیستور: 76.3 میلیارد

- اندازه دای: 608 میلیمتر مربع، فناوری ساخت 5 نانومتری

- پشتیبانی API: از DirectX 12 Ultimate، Vulkan 1.3، OpenGL 4.6، OpenCL 3.0

- ویژگیهای پیشرفته بازی: پشتیبانی از Shader Model 6.7

NVIDIA GeForce RTX 4090 یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، گیمرها و متخصصان خلاق است که با معماری NVIDIA Ada Lovelace قدرت گرفته است. این کارت با 24 گیگابایت حافظه فوقسریع GDDR6X، تصاویر بازی با کیفیت بالا، تولید محتوای سریعتر و قابلیتهای پیشرفته مبتنی بر هوش مصنوعی را ارائه میدهد.

کارت گرافیک GeForce RTX 4080

ویژگیهای کلیدی:

- معماری Ada Lovelace: تا 2 برابر عملکرد و بهرهوری انرژی بالاتری را ارائه میدهد و نوآوریها را در بازی و تولید محتوا به پیش میبرد.

- هستههای RT نسل سوم: ردیابی پرتو تا 2 برابر سریعتر را ارائه میدهد و نورپردازی، سایهها و بازتابهای واقعگرایانه را برای گرافیکهای زنده فراهم میکند.

- هستههای Tensor نسل چهارم: عملکرد هوش مصنوعی را با DLSS 3 تسریع میکند و گیمپلی فوقالعاده روان و کیفیت تصویر بهبودیافته را امکانپذیر میسازد.

- 16 گیگابایت حافظه GDDR6X: ظرفیت و سرعت مورد نیاز برای بازی با وضوح بالا و بارهای کاری خلاقانه پیشرفته را تضمین میکند.

- NVIDIA DLSS 3: از هوش مصنوعی برای افزایش نرخ فریم و بهینهسازی عملکرد بدون افت کیفیت بصری استفاده میکند.

- NVIDIA Reflex: تأخیر سیستم را به حداقل میرساند و پاسخگویی رقابتی را برای بازیهای سریع ارائه میدهد.

- NVIDIA Studio: بهرهوری خلاقانه را با ابزارهای بهینهشده برای رندرینگ، ویرایش و بارهای کاری مبتنی بر هوش مصنوعی بهبود میبخشد.

- درایورهای Game Ready و Studio: عملکرد قابل اعتماد و بهینه را برای وظایف بازی و تولید محتوا ارائه میدهند.

مشخصات:

- هستههای CUDA:حدود 9,728 خط لوله یکپارچه

- سرعت کلاک پایه/بوست: 2,205–2,505 مگاهرتز

- هستههای Ray Tracing: برابر با 76

- هستههای تنسور: 304

- عملکرد نظری: 48.7 ترافلاپس (FP32)

- ظرفیت: 16 گیگابایت GDDR6X

- پهنای گذرگاه حافظه: 256 بیت

- پهنای باند: 716.8 گیگابایت بر ثانیه

- مصرف برق: 320 وات

- تعداد ترانزیستور: 45.9 میلیارد

- اندازه دای: 379 میلیمتر مربع، فناوری ساخت 5 نانومتری

- پشتیبانی API: از DirectX 12 Ultimate، Vulkan 1.3، OpenGL 4.6، OpenCL 3.0

- ویژگیهای پیشرفته بازی: Shader Model 6.7

NVIDIA GeForce RTX 4080 یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، با عملکرد بالا برای مدیریت حجمهای کاری سنگین بازی و خلاقانه است. این کارت فناوریهایی مانند هستههای RT نسل سوم، هستههای Tensor نسل چهارم و DLSS 3 شتابیافته با هوش مصنوعی را ارائه میدهد. RTX 4080 سرعت و کارایی بینظیری را برای گرافیک فراگیر، بهبودهای مبتنی بر هوش مصنوعی و گردشهای کاری بهرهوری فراهم میکند.

کارت گرافیک GeForce RTX 4070 Ti

ویژگیهای کلیدی:

- معماری Ada Lovelace: تا دو برابر عملکرد و بهرهوری انرژی بیشتری نسبت به نسل قبلی ارائه میدهد و برنامههای کاربردی بازی و خلاقانه سطح بعدی را امکانپذیر میسازد.

- هستههای RT نسل سوم: از ردیابی پرتو سریعتر پشتیبانی میکند و نورپردازی، سایهها و بازتابهای فوقالعاده واقعی را در بازیها و پروژههای خلاقانه ارائه میدهد.

- هستههای Tensor نسل چهارم: وظایف مبتنی بر هوش مصنوعی، از جمله DLSS 3 را برای عملکرد تا 4 برابر سریعتر در مقایسه با رندرینگ سنتی بهبود میبخشد.

- 12 گیگابایت حافظه GDDR6X: عملکرد با سرعت بالا را برای وظایف پیشرفته بازی و تولید محتوا تضمین میکند.

- NVIDIA DLSS 3: فناوری مبتنی بر هوش مصنوعی که نرخ فریم را افزایش میدهد و کیفیت تصویر را برای تجربه بازی روانتر بهبود میبخشد.

- NVIDIA Reflex: تأخیر را برای زمان پاسخگویی سریعتر در بازیهای رقابتی کاهش میدهد.

- NVIDIA Studio: بارهای کاری خلاقانه را با ابزارهای بهینهشده برای سازندگان محتوا تسریع میکند.

- درایورهای Game Ready و Studio: عملکرد و پایداری را برای برنامههای کاربردی بازی و حرفهای بهینه میکنند.

مشخصات:

- هستههای CUDA: 7,680

- سرعت کلاک پایه/بوست: 2.31–2.61 گیگاهرتز

- هستههای Ray Tracing: برابر با 93 ترافلاپس

- هستههای تنسور (AI): برابر با 641 TOPS AI

- ظرفیت: 12 گیگابایت GDDR6X

- پهنای گذرگاه حافظه: 192 بیت

- فناوری: Ada Lovelace

- پشتیبانی از Ray Tracing و AI: بله

- بهرهوری انرژی: بهبود یافته نسبت به نسلهای قبلی

- DLSS 3.5: شامل Super Resolution، Frame Generation، Ray Reconstruction و DLAA

NVIDIA GeForce RTX 4070 Ti یک پردازنده گرافیکی با عملکرد بالا برای گیمرها و سازندگانی است که به قابلیتهای گرافیکی پیشرفته و عملکرد کارآمد نیاز دارند. این کارت که بر اساس معماری NVIDIA Ada Lovelace ساخته شده است، دارای هستههای RT نسل سوم، هستههای Tensor نسل چهارم و 12 گیگابایت حافظه فوقسریع GDDR6X است. همین ویژگیها آن را تبدیل به یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 مینماید.

بهترین روشها برای استفاده از کارتهای گرافیک NVIDIA در پروژههای هوش مصنوعی

تیمها و سازمانهای هوش مصنوعی میتوانند از روشهای زیر برای بهبود عملکرد و کارایی هنگام کار با یکی از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 استفاده کنند.

1- بهینهسازی حجمهای کاری با CUDA و cuDNN

CUDA (معماری محاسبات یکپارچه دستگاه)، پایه و اساس اکوسیستم برنامهنویسی کارت گرافیک NVIDIA است که پردازش موازی را برای حجمهای کاری هوش مصنوعی فعال میکند. توسعهدهندگان با بهینهسازی حجمهای کاری با CUDA میتوانند از شتابدهی GPU برای مدیریت وظایف محاسباتی سنگین بهره ببرند. cuDNN (کتابخانه شبکه عصبی عمیق CUDA) با ارائه روالهای بهینهشده برای یادگیری عمیق، مانند کانولوشنها و توابع فعالسازی، CUDA را تکمیل میکند.

برای پیادهسازی این روش، اطمینان حاصل کنید که نرمافزار از APIهای CUDA برای توزیع حجمهای کاری در هستههای GPU استفاده میکند. از cuDNN برای عملیات حیاتی هوش مصنوعی برای بهبود عملکرد در آموزش و استنتاج مدل استفاده کنید. تنظیم مناسب پارامترها، مانند اندازه بلوک و ابعاد شبکه، کارایی را بیشتر افزایش میدهد. ابزارهای پروفایلینگ مانند NVIDIA Nsight Systems و Nsight Compute میتوانند به شناسایی گلوگاهها و بهینهسازی استفاده از بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 کمک کنند.

2- استفاده از مدلهای از پیش آموزشدیده و SDKهای NVIDIA

NVIDIA مجموعهای از مدلهای از پیش آموزشدیده و SDKها، مانند NVIDIA TAO Toolkit و NVIDIA DeepStream را ارائه میدهد که استقرار هوش مصنوعی را ساده میکنند. این منابع با ارائه معماریهای بهینهشده برای وظایفی مانند تشخیص اشیاء، پردازش زبان و تجزیه و تحلیل ویدئو، توسعه را تسریع میکنند.

از مدلهای از پیش آموزشدیده برای صرفهجویی در زمان آموزش از ابتدا، به ویژه برای موارد استفاده رایج، استفاده کنید. این مدلها را با دادهها تنظیم دقیق کنید تا به عملکرد خاص دامنه دست یابید. از SDKهایی مانند TensorRT برای بهینهسازی استنتاج، DeepStream برای تجزیه و تحلیل ویدئو یا Riva برای هوش مصنوعی مکالمهای استفاده کنید.

3- استفاده از Multi-Instance GPU (یا MIG) برای پارتیشنبندی منابع

فناوری Multi-Instance GPU (MIG) NVIDIA امکان پارتیشنبندی یک کارت گرافیک واحد به چندین نمونه مستقل را میدهد که هر کدام منابع اختصاصی خود را دارند. این ویژگی برای محیطهایی با حجمهای کاری متنوع یا زیرساخت GPU مشترک مفید است.

برای به حداکثر رساندن مزایای MIG، الزامات حجم کاری را ارزیابی کرده و نمونههای GPU را بر اساس آن تخصیص دهید. به عنوان مثال، نمونههای جداگانهای را به وظایف استنتاج سبک اختصاص دهید، در حالی که نمونههای بزرگتر را برای آموزش یا محاسبات پیچیده رزرو کنید. از ابزارهای NVIDIA مانند NVIDIA GPU Cloud (یا NGC) و GPU Manager برای پیکربندی و نظارت بر نمونههای MIG استفاده کنید.

4- استفاده از TensorRT برای استنتاج بهینهشده

TensorRT بهینهساز و زمان اجرای استنتاج یادگیری عمیق با عملکرد بالا انویدیاست. این امکان را برای توسعهدهندگان فراهم میکند تا با بهینهسازی مدلها برای استقرار بر روی پردازندههای گرافیکی NVIDIA، کارایی استنتاج را به حداکثر برسانند. TensorRT با استفاده از تکنیکهایی مانند ادغام لایهها و کالیبراسیون دقت، تأخیر را کاهش میدهد، مصرف حافظه را به حداقل میرساند و توان عملیاتی را افزایش میدهد.

برای پیادهسازی این روش، مدلهای آموزشدیده را با استفاده از APIهای آن به فرمتهای بهینهشده TensorRT تبدیل کنید. به تنظیمات دقت، مانند FP16 یا INT8، برای ایجاد تعادل بین عملکرد و دقت توجه کنید. از TensorRT با NVIDIA Triton Inference Server برای استقرار مقیاسپذیر در دیتا سنترها یا دستگاههای لبه استفاده کنید، و استنتاج هوش مصنوعی ثابت و با سرعت بالا را تضمین کنید.

5- اعمال آموزش با دقت ترکیبی

آموزش با دقت ترکیبی از فرمتهای با دقت پایینتر (به عنوان مثال، FP16 یا BF16) در کنار فرمتهای با دقت بالاتر (FP32) برای تسریع محاسبات بدون افت دقت مدل استفاده میکند. بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025، مجهز به هستههای Tensor، برای عملیات با دقت ترکیبی بهینه شدهاند.

برای اعمال آموزش با دقت ترکیبی، از فریمورکهایی مانند TensorFlow یا PyTorch با پشتیبانی از دقت ترکیبی خودکار (AMP) استفاده کنید. اطمینان حاصل کنید که کد از هستههای Tensor برای عملیات سازگار استفاده میکند و دستاوردهای عملکرد را نظارت کنید. آموزش با دقت ترکیبی مصرف حافظه را کاهش میدهد و محاسبات را تسریع میکند، که برای مقیاسبندی آموزش هوش مصنوعی بر روی پردازندههای گرافیکی NVIDIA مفید است.

نتیجهگیری

عملکرد بینظیر را با سرورهای ابری اختصاصی مجهز به پلتفرم محاسباتی شتابیافته انقلابی NVIDIA تجربه کنید. از بین NVIDIA L40S GPU و NVIDIA H100 NVL انتخاب کنید تا پتانسیل کامل حجمهای کاری هوش مصنوعی مولد (AI) خود را آزاد کنید، مدلهای زبانی بزرگ (LLM) را آموزش دهید و از پردازش زبان طبیعی (NLP) در زمان واقعی بهره ببرید.

بهترین کارت های گرافیک انویدیا برای هوش مصنوعی 2025 با عملکرد بالا در تحقیقات علمی، گرافیک و رندرینگ سهبعدی، تصویربرداری پزشکی، مدلسازی آب و هوا، تشخیص تقلب، مدلسازی مالی و پردازش ویدئویی پیشرفته فوقالعاده هستند.

نظرات کاربران